原文地址:https://zhuanlan.zhihu.com/p/20180632

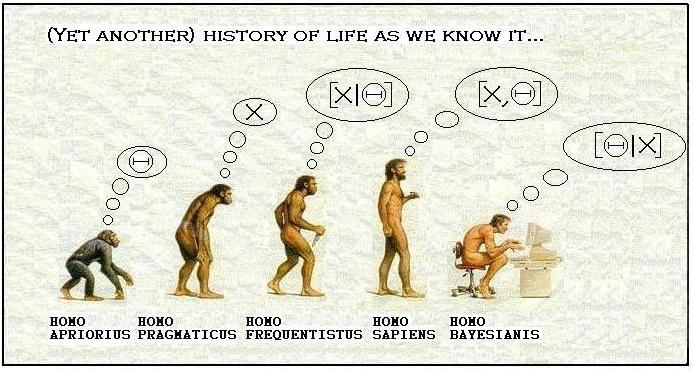

先验学派(apriorius),实用学派(pragmaticus),频率学派(frequentisttus),现代学派(sapiens),贝叶斯学派(bayesianis)

我想每个人都有这样的认识:统计学有两大『学派』:传统的频率学派和贝叶斯学派。正如本文的题图一样,不少人认为频率学派是落后的、原始的,贝叶斯的方法更现代(酷炫)。然而,频率学派和贝叶斯学派之间真的有难以逾越的鸿沟么?

前菜

在介绍正文之前,我们先来一碟前菜,熟悉一下贝叶斯公式热热身。在实践中我们经常会碰到二元选择变量的问题,比如家庭是不是要买车、是否选择外出打工等等问题。令\(d\)为一个二元变量,\(d=1\)或者\(d=0\)。我们的问题是,给定一些特征,\(d=1\)的概率是多少?

用条件概率的描述,我们想知道\(\mathrm{P}(d=1|x)\)。一个很自然的想法是使用贝叶斯公式,我们可以写出:

\[\mathrm{P}(d=1|x)=\frac{f(x|d=1)\mathrm{P}(d=1)}{f(x|d=1)\cdot \mathrm{P}(d=1)+f(x|d=0)\cdot \mathrm{P}(d=0)}=\frac{f(x|d=1)\mathrm{P}(d=1)}{f(x)}\]

现在我们从两个方面解读这个等式。

首先看第一个等号,如果对等号右边做一个变换,可以得到:

\[\mathrm{P}(d=1|x)=\frac{f(x|d=1)\mathrm{P}(d=1)}{f(x|d=1)\cdot \mathrm{P}(d=1)+f(x|d=0)\cdot \mathrm{P}(d=0)}=\frac{\frac{f(x|d=1)\mathrm{P}(d=1)}{f(x|d=0)\mathrm{P}(d=0)}}{1+\frac{f(x|d=1)\mathrm{P}(d=1)}{f(x|d=0)\mathrm{P}(d=0)}}\]

现在令:

\[g(x)=\log(\frac{f(x|d=1)\mathrm{P}(d=1)}{f(x|d=0)\mathrm{P}(d=0)})\]

那么上式就变成了:

\[\mathrm{P}(d=1|x)=\frac{\exp(g(x))}{1+\exp(g(x))}\]

这是什么呢?Logistic(Logit)回归。如果给定\(g(x)\)一些光滑性的假设,可以将\(g(x)\)用 sieve 逼近,从而计算\(\mathrm{P}(d=1|x)\)。注意这里虽然得到了 Logistic 的形式,但是没有做任何分布的假设的。

另一方面,我们来看第二个等号。为了求\(\mathrm{P}(d=1|x)\),必须求出\(f(x|d=1)\)和\(f(x)\)。如果用 kernel 来估计两个密度函数,可以得到:

\[\mathrm{P}(d=1|x)=\frac{f(x|d=1)\mathrm{P}(d=1)}{f(x)}=\frac{\frac{1}{N_dh}\sum{d_i\cdot K(\frac{x-x_i}{h})}\cdot \mathrm{P}(d=1)}{\frac{1}{Nh}\sum{K(\frac{x-x_i}{h})}}=\frac{\sum{d_i\cdot K(\frac{x-x_i}{h})}}{\sum{K(\frac{x-x_i}{h})}}\]

大家看这是啥?对了,这不就是个\(d\)对\(x\)的非参数的回归吗!

用贝叶斯公式得到频率学派的两个方法,是不是很有趣呢?

贝叶斯作为计算方法

当然,以上的前菜仅仅是使用了贝叶斯公式,并不是严谨意义上的贝叶斯「学派」。实际上,更多的人理解的「贝叶斯学派」是一种哲学:与频率学派不同的是,贝叶斯学派把未知的参数看成是一个随机变量。

如果我们有数据X,希望得到参数\(\theta\)的分布,那么根据贝叶斯学派,\(\mathrm{P}(\theta|x)\propto\mathrm{P}(x|\theta)\pi(\theta)\)。熟悉贝叶斯统计的人都应该知道,贝叶斯方法与极大似然估计有千丝万缕的联系。

然而,对于频率学派,除了极大似然估计之外,仍然有很多其他估计方法。比如最为经济学家所喜欢的广义矩估计(GMM),以及 M-estimator 等等。这些方法,与极大似然估计一样,都要最大化某个目标函数,比如GMM的目标函数为:

\[L_n(\theta)=-\left( \frac{1}{\sqrt{n}}\sum{m_i(\theta)} \right)'W_n \left( \frac{1}{\sqrt{n}}\sum{m_i(\theta)} \right)\]

那么这些方法是不是潜在的也可以和贝叶斯学派有些许的相通之处呢?答案是有的。

Victor Chernozhukov 和 Han Hong 2003 年在 JoE 上发表的文章《An MCMC Approach to Classical Estimation》就讲了这么一个故事。

他们提出,如果定义一个『拟后验分布』(Quasi-posterior dsitribution):

\[\mathrm{P}_n(\theta)=\frac{e^{L_n(\theta)}\pi (\theta)}{\int_\Theta e^{L_n(\theta)}\pi (\theta) d\theta}\]

那么后验分布的均值:

\[\hat{\theta}=\int_\Theta \theta p_n(\theta)d\theta\]

在一些相对宽松的条件下,会收敛到真值。注意以上的后验分布的均值可以通过使用 MCMC 方法在后验分布中抽样,继而通过简单对抽样计算平均得到。

注意这里这个方法仍然是传统方法而非贝叶斯方法。在这个方法里面,仍然是有真值的,未知参数并没有像贝叶斯方法那样被假设为一个随机变量。

但是以上的『拟后验分布』非常有意思。试想一下,如果目标函数为极大似然的目标函数,那么以上的『拟后验分布』是不是就变成了贝叶斯统计的『后验分布』了呢?

此外,作者还讨论了 MCMC 作为一个抽样、计算积分的算法在这里与『模拟退火』算法的相通之处,所以在频率学派看来,贝叶斯方法提供了一个计算最优值的不错的算法。

贝叶斯的频率方法

上面介绍了频率方法的贝叶斯视角,那么反过来,是不是贝叶斯方法也有频率的视角呢?答案是有的。

一般来讲,传统的贝叶斯方法很少讨论样本量对统计量的影响情况,那么当样本趋向于无穷时,贝叶斯统计量究竟有何种表现呢?

Jiti Gao在一篇会议论文《A Frequency Approach to Bayesian Asymptotics》中讨论了这一问题。证明过程这里略过,说一下结论,他证明出,在一些比较宽松的条件下,当模拟次数M、样本量N同时趋向于无穷时,贝叶斯统计量与传统方法(如 MLE)的统计量有相同的渐进分布。

结论

对于『贝叶斯学派』和『频率学派』有很多争议,然而最新的这些发现却给了我们一些新的视角,这两个学派之间并没有我们之前想象的巨大的鸿沟。是不是很有趣呢?